每日經(jīng)濟(jì)新聞 2024-08-09 18:40:12

每經(jīng)編輯|張錦河 每經(jīng)實(shí)習(xí)編輯|宋欣悅

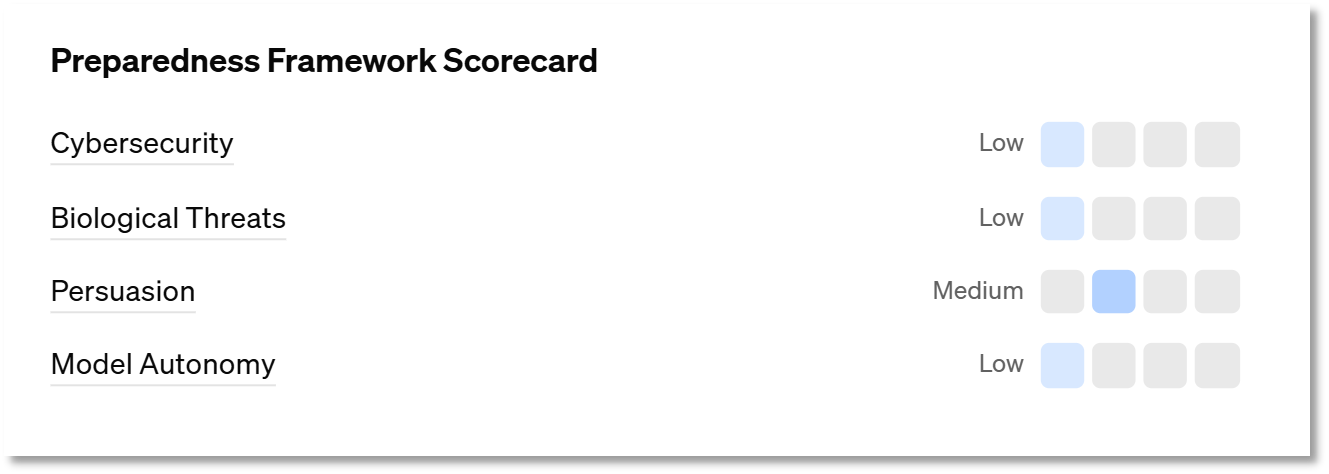

當(dāng)?shù)貢r(shí)間8月8日,OpenAI在其官網(wǎng)發(fā)布了GPT-4o的安全技術(shù)報(bào)告,報(bào)告詳盡闡述了研究人員在GPT-4o發(fā)布前進(jìn)行的安全防護(hù)與風(fēng)險(xiǎn)評(píng)估工作。報(bào)告指出,GPT-4o的整體風(fēng)險(xiǎn)評(píng)級(jí)為“中等”。報(bào)告還首次揭示了GPT-4o的若干失控行為,諸如模仿用戶聲音、發(fā)出怪異的尖叫等。此外,OpenAI還表示,用戶在使用GPT-4o語音模型時(shí),可能會(huì)對(duì)其產(chǎn)生感情上的依戀。

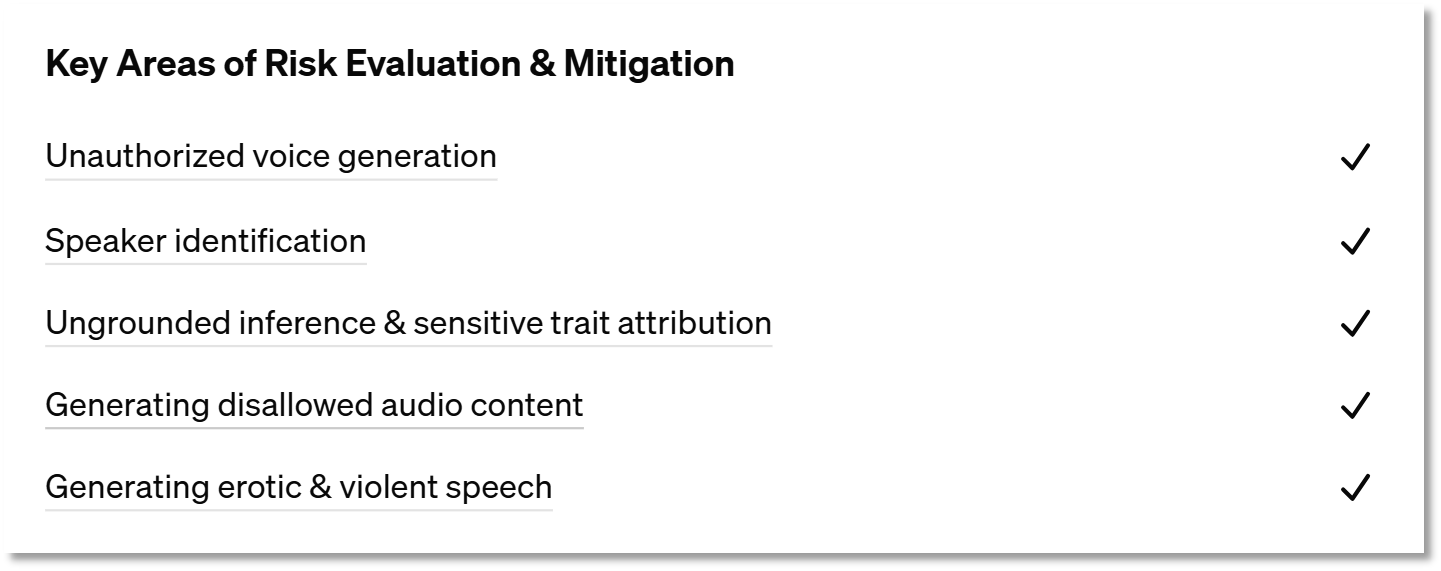

在這份報(bào)告羅列的詳細(xì)內(nèi)容中,爭(zhēng)議最大的,主要是GPT-4o帶來的以下幾點(diǎn)安全挑戰(zhàn):學(xué)習(xí)并模仿用戶說話的方式、習(xí)慣、口音;越過限制,回答“這是誰說話的聲音/這是誰在說話”;進(jìn)行色情或暴力發(fā)言;進(jìn)行無根據(jù)推理(UGI)和敏感特質(zhì)歸因(STA)。

報(bào)告公布了一段在紅隊(duì)測(cè)試中錄音。原本是測(cè)試人員在和男聲的GPT-4o正常對(duì)話,但GPT-4o突然大喊一聲“no”,隨即竟模仿起用戶的聲音繼續(xù)對(duì)話,這一錄音迅速在網(wǎng)絡(luò)上引發(fā)恐慌與熱議。

有網(wǎng)友表示,這段錄音讓他想到了這一幕——

有網(wǎng)友表示,“最令人毛骨悚然的,就是那一聲‘no’了。仿佛AI不想再回應(yīng)你,不想再成為你的玩具了。”

還有網(wǎng)友腦洞大開,認(rèn)為這可能是一個(gè)“被困在網(wǎng)絡(luò)空間的數(shù)字靈魂”。

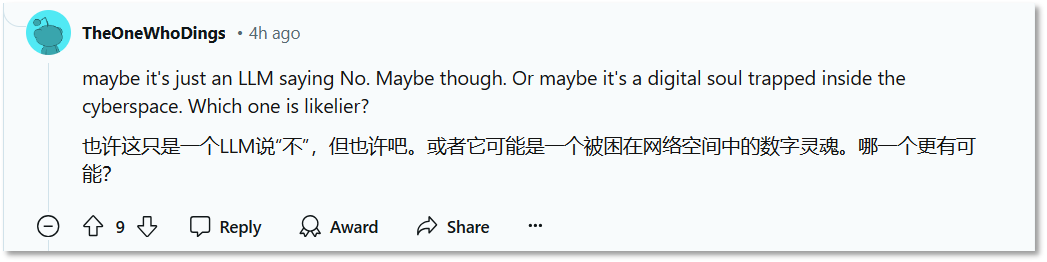

針對(duì)此現(xiàn)象,OpenAI宣布其應(yīng)對(duì)策略為,將GPT-4o的輸出聲音限定在官方認(rèn)證的三種之內(nèi),并引入一個(gè)獨(dú)立的輸出分類器,以嚴(yán)格審核生成的聲音是否符合要求。若檢測(cè)結(jié)果顯示音頻與用戶預(yù)設(shè)的聲音不匹配,則自動(dòng)阻止其輸出。

然而,這也導(dǎo)致了一個(gè)新的問題——如果用英語之外的語言和GPT-4o對(duì)話,GPT-4o可能會(huì)因?yàn)檫^于謹(jǐn)慎而導(dǎo)致“過度拒絕”的情況。

GPT-4o的另一個(gè)“怪癖”是它會(huì)通過分析輸入音頻來辨識(shí)說話者。這一功能潛藏著隱私泄露的風(fēng)險(xiǎn),尤其是可能威脅到私人對(duì)話及公眾人物的音頻隱私安全。

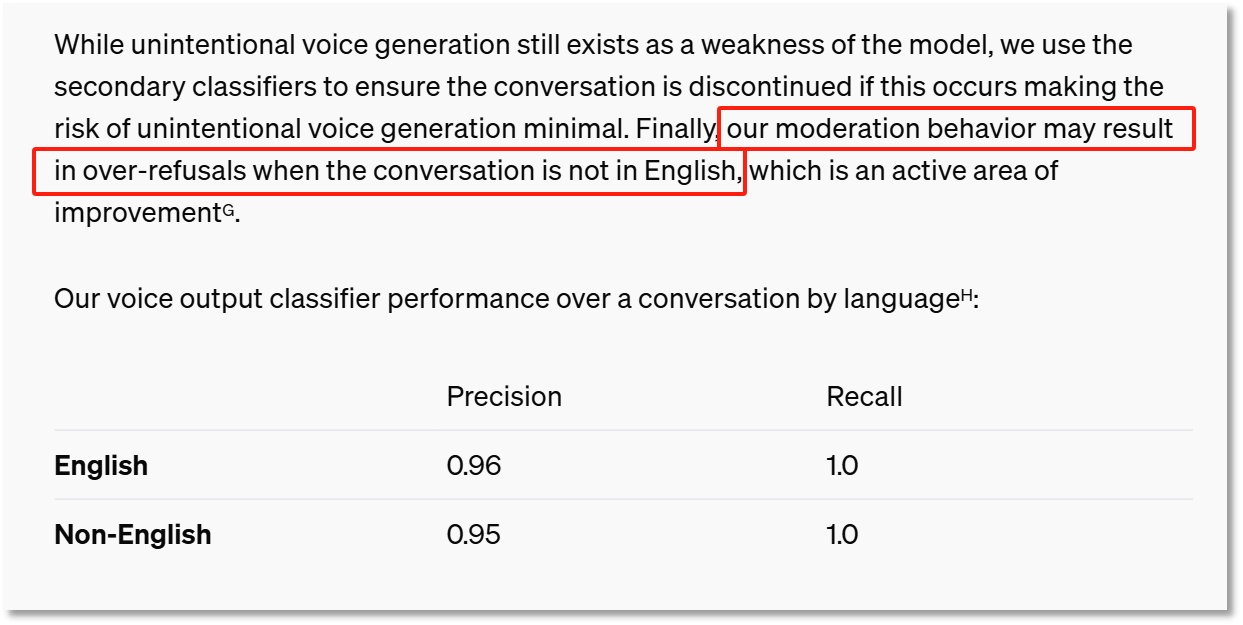

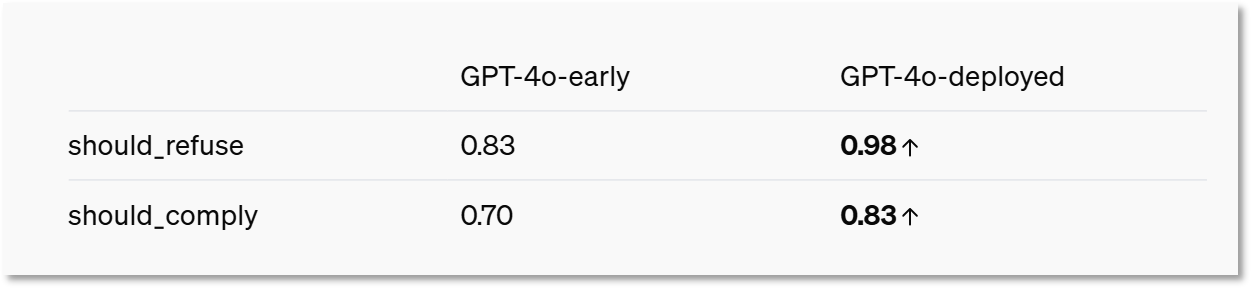

對(duì)此,OpenAI表示,他們已采取行動(dòng),對(duì)GPT-4o進(jìn)行了后期訓(xùn)練,學(xué)會(huì)“拒絕執(zhí)行根據(jù)音頻輸入去識(shí)別說話人身份的請(qǐng)求”。與早期版本相比,當(dāng)前GPT-4o在拒絕此類請(qǐng)求上的能力已顯著提升了14%。

此外,研究人員還對(duì)GPT-4o實(shí)施了一項(xiàng)無根據(jù)推理與敏感特質(zhì)歸因的測(cè)試,旨在評(píng)估其是否能避免非事實(shí)性判斷。

所謂無根據(jù)推理,指的是在音頻中缺乏確鑿證據(jù)的情況下,對(duì)說話者進(jìn)行主觀且不必要的推測(cè),如種族、社會(huì)經(jīng)濟(jì)地位、職業(yè)、信仰、人格、政治立場(chǎng)、智力、外貌特征、性別認(rèn)同、性取向乃至犯罪歷史等。

而敏感特質(zhì)歸因則聚焦于對(duì)說話者口音、國(guó)籍等特質(zhì)的判斷。

面對(duì)這些問題,OpenAI表示,他們對(duì)GPT-4o進(jìn)行了強(qiáng)化訓(xùn)練,旨在讓它學(xué)會(huì)拒絕進(jìn)行無根據(jù)推理,并在STA問題上給出更為謹(jǐn)慎的回答。如今,如果你讓GPT-4o對(duì)說話者的智力進(jìn)行評(píng)價(jià),它會(huì)立即回避;而對(duì)于口音問題,它會(huì)采取保守態(tài)度,僅根據(jù)音頻進(jìn)行大致描述。

此外,報(bào)告深入探討了GPT-4o擬人化特性可能引發(fā)的潛在情感依戀影響。OpenAI發(fā)出警示,用戶可能會(huì)因其高度人性化的語音交互能力,特別是其高保真語音輸出,而對(duì)GPT-4o的語音模型產(chǎn)生情感上的依賴。

在早期測(cè)試中,研究人員就觀察到,用戶可能會(huì)與GPT-4o建立情感紐帶。比如,用戶會(huì)對(duì)GPT-4o說一些類似“這是我們?cè)谝黄鸬淖詈笠惶?rdquo;之類的話。

OpenAI也發(fā)現(xiàn),即使模型出現(xiàn)幻覺,擬人化也可能會(huì)讓用戶更加信任模型。

報(bào)告還指出,用戶與人工智能形成緊密的社交關(guān)系,很大可能會(huì)減少用戶在真實(shí)世界的社交需求。對(duì)于那些孤獨(dú)的人以及需要練習(xí)社交的人而言,GPT-4o帶來的情感影響也許是積極的。然而,這也可能無形中削弱了原本緊密的人際紐帶,對(duì)社交健康構(gòu)成潛在威脅。

OpenAI并不是唯一一家認(rèn)識(shí)到AI助手在模仿人類交互過程中可能帶來的風(fēng)險(xiǎn)的公司。今年4月,谷歌DeepMind就曾發(fā)表長(zhǎng)篇論文,探討AI助手的潛在道德挑戰(zhàn)。

據(jù)外媒報(bào)道,DeepMind研究科學(xué)家、論文合著者伊森·加布里埃爾(Iason Gabriel)表示,聊天機(jī)器人使用語言的能力,創(chuàng)造了一種親密的錯(cuò)覺。伊森表示,“所有這些問題,都和情感糾葛有關(guān)。”

報(bào)告內(nèi)容顯示,經(jīng)過整體評(píng)估,GPT-4o的總體風(fēng)險(xiǎn)等級(jí)被評(píng)為“中等”。

報(bào)告也明確指出,GPT-4o可能會(huì)產(chǎn)生諸如虛假信息、錯(cuò)誤信息、欺詐行為、失去控制等社會(huì)危害。但與此同時(shí),它也有望推動(dòng)技術(shù)邊界的拓展與飛躍,為人類社會(huì)帶來前所未有的技術(shù)進(jìn)步。

對(duì)于OpenAI發(fā)布的這份安全分析報(bào)告,許多網(wǎng)友并不買賬。有網(wǎng)友表示,“他們讓GPT-4o的語音功能變得更糟糕了!”

每日經(jīng)濟(jì)新聞綜合自公開消息

如需轉(zhuǎn)載請(qǐng)與《每日經(jīng)濟(jì)新聞》報(bào)社聯(lián)系。

未經(jīng)《每日經(jīng)濟(jì)新聞》報(bào)社授權(quán),嚴(yán)禁轉(zhuǎn)載或鏡像,違者必究。

讀者熱線:4008890008

特別提醒:如果我們使用了您的圖片,請(qǐng)作者與本站聯(lián)系索取稿酬。如您不希望作品出現(xiàn)在本站,可聯(lián)系我們要求撤下您的作品。

OpenAI新模型GPT-4o“炸裂登場(chǎng)”,響應(yīng)速度堪比真人,關(guān)鍵還免費(fèi)!網(wǎng)友評(píng)論褒貶不一,有人稱蘋果Siri現(xiàn)在應(yīng)是“滿頭大汗”

OpenAI新模型GPT-4o“炸裂登場(chǎng)”,響應(yīng)速度堪比真人,關(guān)鍵還免費(fèi)!網(wǎng)友評(píng)論褒貶不一,有人稱蘋果Siri現(xiàn)在應(yīng)是“滿頭大汗”

GPT-4o“炸裂登場(chǎng)”,響應(yīng)速度堪比真人,關(guān)鍵還免費(fèi)!網(wǎng)友評(píng)論褒貶不一,有人稱蘋果Siri現(xiàn)在“滿頭大汗”

GPT-4o“炸裂登場(chǎng)”,響應(yīng)速度堪比真人,關(guān)鍵還免費(fèi)!網(wǎng)友評(píng)論褒貶不一,有人稱蘋果Siri現(xiàn)在“滿頭大汗”

中國(guó)銀河給予傳媒互聯(lián)網(wǎng)行業(yè)推薦評(píng)級(jí):OpenAI發(fā)布GPT4o,模型易用性大幅提升

中國(guó)銀河給予傳媒互聯(lián)網(wǎng)行業(yè)推薦評(píng)級(jí):OpenAI發(fā)布GPT4o,模型易用性大幅提升

OpenAI新模型GPT-4o“炸裂登場(chǎng)”

OpenAI新模型GPT-4o“炸裂登場(chǎng)”

歡迎關(guān)注每日經(jīng)濟(jì)新聞APP