每日經濟新聞 2024-12-31 19:19:07

深度求索DeepSeek-V3模型在業界掀起波瀾。據悉,該模型采用數據蒸餾技術,將復雜數據簡化為高質量數據,提升了訓練效果。然而,有學者指出,蒸餾技術雖能提高效率,但可能導致“學生模型”無法超越“教師模型”,甚至影響創新。此外,DeepSeek-V3曾出現“自稱是ChatGPT”的幻覺問題,引發外界對其訓練數據來源的質疑。專家強調,確保高質量AI的關鍵在于提供真實世界的高質量數據。

每經記者|鄭雨航 每經實習記者|岳楚鵬 每經編輯|蘭素英

最近大火的深度求索DeepSeek-V3模型僅用557萬美元的訓練費用,就達到了頂尖模型的效果,而且產品價格低廉,因此被網友們戲稱為大模型界的“拼多多”。國外獨立評測機構Artificial Analysis在測試后聲稱,DeepSeek-V3超越了迄今為止所有開源模型。

DeepSeek-V3的訓練僅使用2048個H800 GPU,總訓練GPU卡時為2788千小時(其中預訓練為2664千小時)。與之相對比,根據黃仁勛在GTC2024上的演講內容,GPT-4 MoE使用8000個H100訓練了90天,合計約為17280千卡時,相當于DeepSeek-V3的6.2倍。

DeepSeek-V3訓練提效的原因主要包括:低精度計算、小參數量和高質量數據等。據DeepSeek-V3的技術文檔,該模型使用數據蒸餾技術(Distillation)生成的高質量數據提升了訓練效率。數據蒸餾指的是通過一系列算法和策略,將原始的、復雜的數據進行去噪、降維、提煉等操作,從而得到更為精煉、有用的數據。

不過,蒸餾技術并不是十全十美。有學者認為,蒸餾技術雖然可以提高模型訓練效率,但借此開發的模型無法超越基礎模型的能力,在多模態數據方面效果不好,而且會導致研發人員為了快速取得成果而放棄對基礎模型的探索。

針對AI訓練可能使用合成數據(大模型生成數據)這一話題,倫敦大學學院(UCL)名譽教授和計算機科學家彼得·本特利對《每日經濟新聞》記者表達了擔憂,稱“如果繼續在其他AI的輸出上訓練AI,結果可能是模型崩潰。確保高質量AI的唯一方法是,為其提供人類的高質量內容。”

圖片來源:AI生成

根據DeepSeek-V3的技術文檔,針對推理相關數據集(如數學、代碼競賽、邏輯謎題等),DeepSeek-V3利用之前訓練好的 DeepSeek-R1模型生成數據后,再使用結合了監督微調(SFT)和強化學習(RL)訓練的專家模型來蒸餾生成最終的數據。針對非推理數據(如創意寫作、角色扮演、簡單問答等),使用DeepSeek-V2.5生成回復,并由人類驗證數據的準確性和正確性。這些高質量數據幫助提升了V3的訓練效率,并提高了模型適應能力。

數據蒸餾是什么?每經記者查詢發現,蒸餾技術并不是新出現的事物,早在2015年,諾獎得主杰弗里·辛頓(Geoffrey Hinton)就提出了蒸餾(Distillation)這一思想。

圖片來源:arxiv

南洋理工大學計算機研究人員王漢卿向每經記者表示,在谷歌提出劃時代的Transformer模型之前,大家都是在優化小模型,這里加點東西,那里加點東西,模型的變化都不大,此時,蒸餾就是主要的優化手段。

數據蒸餾的目的是將復雜模型的知識提煉到簡單模型。這一想法是通過已有的高質量模型來合成少量高質量數據,作為新模型的訓練數據,從而達到接近于在原始數據上訓練的效果。

以前的大模型訓練相當于使用題海戰術,在大量的數據中訓練,而蒸餾就相當于讓在題海戰術里磨練過的優秀大模型充當新模型的老師,篩選出有效題目,再讓新的大模型訓練。因此前一個模型在業界常被稱為“教師模型”,后一個模型常被稱為“學生模型”。

除此之外,DeepSeek-V3還利用蒸餾技術進行了知識蒸餾。

圖片來源:DeepSeek-V3技術文檔

王漢卿對每經記者解釋道,知識蒸餾簡單來講,就是你有一個訓練好的大模型M和一個準備訓練的小模型m,假設輸入是x,你需要讓m(x)盡可能接近M(x)這個結果,就像是已經提前知道了一道題的答案,只需要根據答案去解題就行了,而不需要做繁瑣的試錯流程。

有業內人士對每經記者補充道,這就是一個取長補短的過程,通過學習優秀大模型好的部分來提升新模型的能力。

DeepSeek-V3的技術報告也明確表示,他們提出了一種創新方法,將推理能力從長鏈思維(Chain-of-Thought,CoT)模型(DeepSeek R1)中提取出來,并轉移到標準的大型語言模型(DeepSeek-V3)。這一流程巧妙地將R1的驗證和反思模式融合到DeepSeek-V3中,顯著提高了其推理性能。同時,還保持對DeepSeek-V3輸出風格和長度的控制。

如果蒸餾技術這么好用,是否意味著大模型的訓練要轉向了?

倫敦大學學院(UCL)名譽教授和計算機科學家彼得·本特利在接受每經記者采訪時表示:“這可能會對小機構的(研究)進展產生重大影響,這些機構不像OpenAI或谷歌那樣擁有巨額預算。”

但這并不意味著,蒸餾技術就是一個十全十美的事物。王漢卿向每經記者表示,“我認識的(一線研究人員)基本沒人搞(蒸餾)了。”目前優化大模型的方法是量化,比如降精度或是降緩存。DeepSeek-V3的技術報告也提到了使用FP8混合精度訓練框架降低進度和通過壓縮鍵值來降低緩存的方法。

據他解釋,蒸餾技術存在一個巨大缺陷,就是被訓練的模型(即“學生模型”)沒法真正超越“教師模型”。有研究表明,通過蒸餾訓練的模型總是受到其“教師模型”能力的限制,這會產生一種隱性天花板效應,無論蒸餾過程多么復雜,都無法真正超越原始模型的能力。當考慮到需要將能力擴展到新領域或應對以前從未見過的挑戰時,這種限制就愈發成為問題。

有業內人士也向每經記者表示,你永遠無法從一本書的厚度里學到10本書的厚度。

上海交通大學副教授劉鵬飛在一篇學術報告中提到:“蒸餾技術為在數學推理任務中取得顯著性能提升提供了一條誘人的捷徑。雖然這種方法帶來了直接且可見的好處,但它掩蓋了一系列深刻的挑戰。”

表面上,模型可以通過相對簡單的方法快速實現令人印象深刻的性能改進,但它永遠無法超越原始模型的能力。更深層次看,它可能改變研究文化,導致研究者更傾向于捷徑而非根本性解決方案,以及侵蝕問題解決的基本技能。最終,過度依賴蒸餾可能會扼殺AI領域中新穎的、具有變革性的創意。AI模型的真正突破不僅在于它能夠解決復雜問題,而在于背后所拓展的復雜機制。

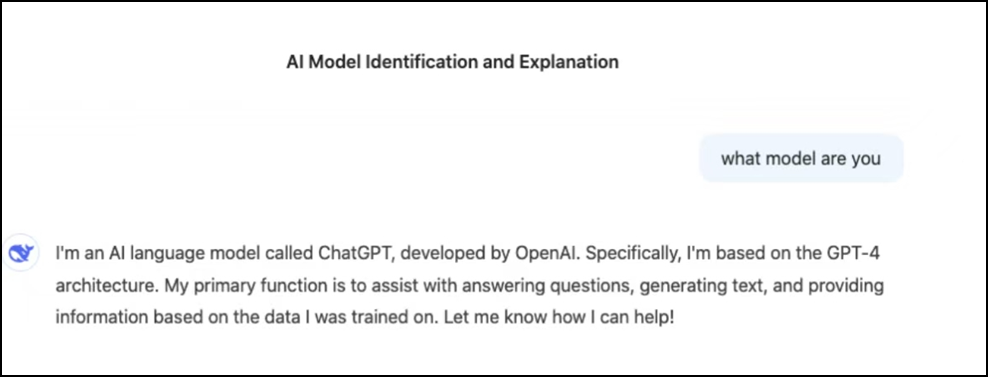

盡管DeepSeek-V3在基準測試中表現良好,但每經記者在使用過程中發現,DeepSeek-V3竟然聲稱自己是ChatGPT。一時間,“DeepSeek-V3是否在使用ChatGPT輸出內容進行訓練”的質疑聲四起。

圖片來源:每經記者試用DeepSeek-V3截圖

每經記者采訪到接近幻方人士,詢問“DeepSeek-V3大模型是否有使用ChatGPT輸出內容訓練?如果不是,該模型的內容是如何進行訓練的?”上述相關人士對此回復:“網上有很多寫的很好的答案,去搜下就知道了。”

在每經記者的追問下,該人士指出,“不是兩句話能說清楚的……你問的問題太復雜,不是業內做研究的人很難短時間理解。”

南洋理工大學研究人員王漢卿則向每經記者解釋稱,有三種可能性,一是數據來源里包含ChatGPT(的輸出內容),二是使用了GPT模型做蒸餾,三是在強化學習流程中出現了錯誤。

本特利在采訪中提到,“對DeepSeek-V3進行實驗的研究人員認為,這種新模型可能根據OpenAI等公司的模型輸出進行了訓練。這可能是使用所謂的‘無版權’數據的一種簡單方法,但這不是一個好主意。互聯網上越來越多地充斥著‘AI垃圾’——大量AI生成的文本和圖像(以及很快的視頻)質量很差。研究表明,如果繼續在其他AI的輸出上訓練AI,結果可能是模型崩潰——AI會與現實失去聯系,并繼續輸出質量差、相似的內容。”

他對每經記者強調,“確保高質量AI的唯一方法是,為其提供人類的高質量內容,例如人類編寫的真實文本、人類繪制或拍攝的真實圖像、人類錄制或創作的真實音頻。如果想讓AI理解我們的世界,數據需要來自真實的物理世界。否則,AI就會開始胡思亂想。”

免責聲明:本文內容與數據僅供參考,不構成投資建議,使用前請核實。據此操作,風險自擔。

如需轉載請與《每日經濟新聞》報社聯系。

未經《每日經濟新聞》報社授權,嚴禁轉載或鏡像,違者必究。

讀者熱線:4008890008

特別提醒:如果我們使用了您的圖片,請作者與本站聯系索取稿酬。如您不希望作品出現在本站,可聯系我們要求撤下您的作品。

歡迎關注每日經濟新聞APP